Ein neues Zeitalter der Signal- und Bildverarbeitung

Mathematische Modelle sind die Grundlage industrieller Innovationen

von Christoph SchnörrStrömungen in Gasen und Flüssigkeiten sind allgegenwärtig und grundlegend für das Verständnis einer großen Zahl naturwissenschaftlicher Fragestellungen und technologischer Anwendungen, von mikromechanischen Problemen bis hin zum Entwurf eines Raumgleiters, von Untersuchungen in Windkanälen für die Automobilindustrie bis hin zur Auslegung von Prozessen zur Nahrungsmittelproduktion.

Obwohl die strömungsphysikalischen Grundgleichungen, die sogenannten Navier-Stokes-Gleichungen, schon seit dem 19. Jahrhundert bekannt sind, mangelt es an einem hinreichenden Verständnis für die Prädiktion turbulenter Strömungen in konkreten Szenarien. Die entsprechende Forschungslandschaft gliedert sich in drei Gebiete:

Für dreidimensionale Strömungen ist es mathematischen Analytikern bisher nicht gelungen, aus den Navier-Stokes-Gleichungen auf die Existenz physikalischer plausibler Lösungen zu schließen. Diese Verständnislücke ist so grundlegend, dass sie in die Reihe der „Millennium-Probleme“ aufgenommen wurde, für deren Lösung das Clay-Institut für Mathematik in Cambridge, USA, ein Preisgeld von jeweils einer Million Dollar ausgelobt hat.

Ein weiteres Gebiet beschäftigt sich mit der numerischen Simulation von Lösungen der Navier-Stokes-Gleichungen, genauer mit Annäherungen dieser Gleichungen, sodass sie mit einem Computer verarbeitet werden können. Die Herausforderung besteht darin, die direkte Simulation großskaliger Phänomene mit der Modellierung kleinskaliger turbulenter Phänomene, deren Freiheitsgrade in einem Rechner nicht direkt dargestellt werden können, zu verbinden.

Das dritte Gebiet, die Experimentelle Strömungsmechanik, erforscht Techniken zur Vermessung turbulenter Strömungen, weil eine zuverlässige Vorhersage in konkreten Situationen noch nicht hinreichend genau möglich ist. Optische Techniken und Bildverarbeitung spielen dabei eine wichtige Rolle. Zu den strategischen Fragestellungen, welche die aktuelle Forschung dominieren, gehören:

Wie modelliert und verbindet man datengetriebene und modellgestützte Verfahren zur Bildanalyse, d.h. die von Messwerten gelieferten Informationen in Form eines Modells desjenigen Prozesses, der diese Daten erzeugt? Dieses Problem ist grundlegend für jede Datenauswertung. In der Experimentellen Strömungsmechanik dominieren bisher jedoch die rein datengetriebenen Verfahren. Forschungsarbeiten zur Integration physikalischen Vorwissens erfolgen daher von unserer Arbeitsgruppe im Rahmen eines DFG-Schwerpunktprogramms.

Wie kann man messtechnisch mittels zweidimensionaler Daten dreidimensionale Strömungen in räumlich-zeitlich hoher Auflösung erfassen? Diese Frage treibt derzeit einen Paradigmenwechsel des Arbeitsgebiets voran.

Wie schließt man die Lücke zwischen Experiment und Simulation? Diese Frage definiert die Synergie zwischen dem zweiten und dritten Arbeitsgebiet als langfristiges Ziel. Befriedigende Lösungsansätze auf der Basis von Turbulenzmodellen stehen noch aus.

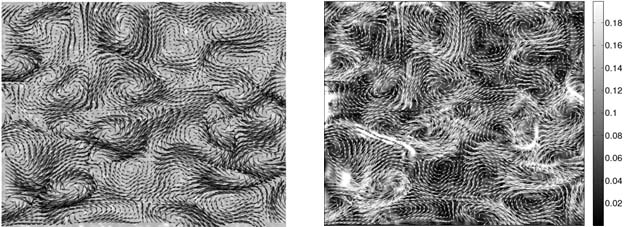

Vergleichstest für PIV-Methoden: Im linken Bild ist die zu schätzende turbulente Strömung einer Computersimulation der Navier-Stokes-Gleichung zu sehen. Das rechte Bild zeigt zum Vergleich die lediglich anhand von Partikelbildern geschätzte Strömung mit den Navier-Stokes-Gleichungen als Nebenbedingung. Als Hintergrund der Vektoren ist im rechten Bild die Ungenauigkeit der Schätzung als Grauwert gezeigt, gemäß der Skala am rechten Bildrand. (Einheit: Pixel). Die durchschnittliche Schätzungsgenauigkeit von 0,055 Pixel demonstriert die prinzipielle Leistungsfähigkeit mathematischer Bildverarbeitungsverfahren.

Particle Image Velocimetry (PIV)

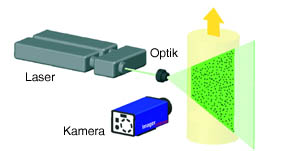

Die Abbildung auf Seite 4 (links) illustriert und erläutert den typischen Aufbau zur optischen Strömungsvermessung mittels „Particle Image Velocimetry“. Individuelle Anforderungen an die Sensorik und die apparative Datenerfassung werden heutzutage von einigen spezialisierten Firmen kommerziell und international erfolgreich bedient.

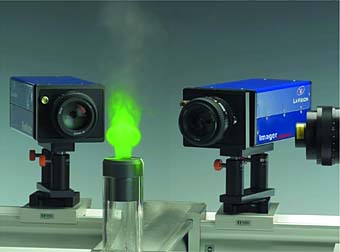

Entsprechende Systeme sind so ausgereift, dass sie als plug-and-play-Lösung mit hoher zeitlicher und räumlicher Auflösung Bildfolgen turbulenter Strömungen aufzeichnen können (siehe Abbildung auf Seite 8 (Mitte)). So wurde beispielsweise aktuell ein solches System (mit feinsten Luftblasen anstelle echter Partikel) benutzt, um Schwimmtechniken des US-Olympiateams zu analysieren und zu verbessern. Gleichzeitig hat sich die Forschergemeinde auf standardisierte Vergleichtests für Verfahren zur Auswertung solcher Daten geeinigt, sogenannte PIV-Challenges, die in periodischen Abständen entworfen und von einem internationalen Gremium durchgeführt werden.

Datengetriebene adaptive Bildanalyse

Die von einem PIV-System erzeugten Messdaten stellen die anschließende computergestützte Auswertung vor große Herausforderungen, nicht nur wegen der enormen Datenmenge. Aus einer Zeitreihe verrauschter Bilddaten mit inhomogenen Partikelverteilungen (siehe Abbildung auf Seite 8 (Mitte)) soll das Geschwindigkeitsfeld der turbulenten Strömung berechnet werden, indem man die Partikel in aufeinanderfolgenden Bildern einander zuordnet. Die Abbildung oben zeigt einen kleinen Ausschnitt eines solchen Feldes. Dabei wird die momentane Geschwindigkeit der Strömung an einem Ort jeweils durch die Größe und Richtung eines Pfeils angegeben, so wie man es aus dem Wetterbericht des Fernsehens kennt.

Um die in der Abbildung auf Seite 8 gezeigten Rauscheinflüsse zu unterdrücken, mittelt man geschätzte Geschwindigkeiten in einer kleinen Umgebung. Dies ist kein Problem, wenn die Geschwindigkeiten konstant sind, wohl aber ein Problem, wenn diese variieren. Denn dann wird lediglich eine mittlere Geschwindigkeit berechnet und Information, die in der Variation der Geschwindigkeiten selbst steckt, geht verloren. Genau diese Information charakterisiert aber turbulente Strömungen.

Die Regeln für einen optimalen Kompromiss zwischen Rauschunterdrückung durch Mittelung einerseits, und örtlicher Auflösung der Geschwindigkeitsschätzung andererseits, sind sehr schwer explizit anzugeben, zumal die Entscheidung an einem bestimmten Ort im Bild von den Entscheidungen in der Umgebung abhängt. Im Gegensatz dazu kann man jedoch mathematisch die sich widersprechenden Kriterien so zu einem einzigen Optimierungsproblem kombinieren, dass die Verarbeitungsregeln „automatisch“ von einem Programm erzeugt werden, und dies adaptiv und individuell an jeder Stelle des Bildes beziehungsweise der Strömung. Diese in der Abbildung oben illustrierte Technik erzielt für PIV-Challenge-Testdaten höchste Genauigkeit.

Steuerung durch physikalisches Vorwissen

Eine Grundregel der Datenverarbeitung fordert, verfügbares Vorwissen über die Interpretation der Daten auszunutzen. Diese Regel wurde bisher insofern verletzt, als die oben bereits erwähnten Navier-Stokes-Gleichungen, welche die zu schätzenden Strömungen mathematisch beschreiben, bisher nicht berücksichtigt wurden. Einer der Gründe hierfür liegt darin, dass diese Gleichungen Strömungen, die lediglich innerhalb einer Schnittebene durch den Raum sichtbar sind, nicht direkt beschreiben.

Mit Blick auf den im folgenden Absatz skizzierten sich derzeit abzeichnenden Wechsel hin zur 3D-Messtechnik wurde von unserer Arbeitsgruppe dennoch eine entsprechende Studie für den 2D-Fall vorgenommen. Dabei wurde von dem geschätzten Geschwindigkeitsfeld (siehe Abbildung auf Seite 6) zusätzlich als Nebenbedingung des Optimierungsproblems verlangt, dass es eine geeignete Version der Navier-Stokes-Gleichungen erfüllen soll. Daraus resultiert ein Steuerungsproblem: Berechne eine Lösung der strömungsphysikalischen Grundgleichungen so, dass diese möglichst gut die beobachteten Partikelbewegungen in der Bildfolge beschreibt. Lösungsverfahren „simulieren“ im Computer das physikalische System und steuern seinen Zustand zur Bestimmung unbekannter Freiheitsgrade derart, dass dieser Zustand mit den Messwerten des „real“ beobachteten Systems übereinstimmt. Dies ist ein wesentlicher Schritt, um die eingangs genannte Lücke zwischen Experiment und Simulation zu schließen. Die Abbildungen oben illustrieren das Potenzial dieser Vorgehensweise.

Paradigmenwechsel: dreidimensionale tomographische PIV

Strömungen und die entsprechende Physik gelten für den dreidimensionalen Raum. Es stellt sich deshalb die natürliche Frage, inwieweit durch zweidimensionale Messungen (Bilder) dreidimensionale Strömungen mit guter Auflösung erfasst werden können.

Aus der medizinischen Bildverarbeitung ist eine Vorgehensweise, welche dies leistet, wohlbekannt: Computertomographen nehmen Projektionen des abzubildenden Volumens aus vielen Richtungen auf. Die Rekonstruktion des Volumenbildes aus diesen Projektionsbildern durch den Computer für die anschließende Inspektion durch den Arzt ist Routine.

In der Experimentellen Strömungsmechanik ist diese Vorgehensweise jedoch aus zweierlei Gründen nicht durchführbar. Einerseits ist die erforderliche Frequenz der Bildaufnahme um Größenordnungen höher. Andererseits wären solche Systeme für den Anwender unflexibel und unerschwinglich. Vielmehr möchte man mit wenigen Hochgeschwindigkeitskameras auskommen.

Ein negative Konsequenz dieser Anforderungen ist, dass Standardverfahren der medizinischen Bildverarbeitung nicht anwendbar sind. Ob absicherbare Alternativen existieren, und wie diese aussehen, ist eine weitere Frage an die Mathematik.

Rekonstruierbarkeit von Volumina aus Projektionen

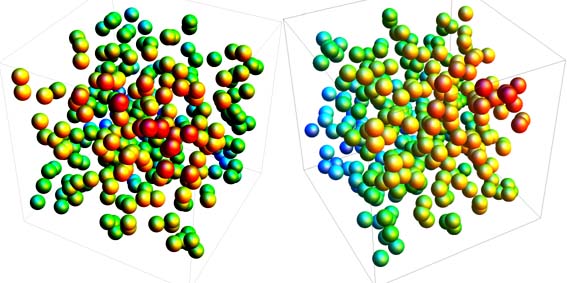

Wir versuchen zunächst intuitiv die Frage zu beantworten, ob die Rekonstruktion eines Volumenbildes in der Experimentellen Strömungsmechanik ein realistisches Unterfangen ist. Dazu betrachten wir in der Abbildung auf Seite 8 (unten) drei Projektionen (Kamerabilder) eines würfelförmigen Volumens, das 300 Partikel enthält, deren Anordnung stilisiert die Abbildung auf Seite 5 zeigt.

Jedes der drei Kamerabilder liefert d2-Datenpunkte, die Pixel eines digitalen Bildes, wie die Abbildung auf Seite 12 verdeutlicht. Kann man aus den Daten der drei Bilder das Volumen mit d3-Punkten rekonstruieren?

Der Leser wird sich daran erinnern, dass man zur Bestimmung von „n“ Variablen „n“ Gleichungen benötigt. Hat man weniger Gleichungen, so ist das Problem unterbestimmt und hat keine eindeutige Lösung. Genau diese Situation liegt in unserem Fall schon ab d 4 vor. Für typische Größen von „d“ ist das Rekonstruktionsproblem sogar dramatisch unterbestimmt.

Die Rekonstruktion „irgendeines“ Volumens, das mit den Daten kompatibel ist, macht keinen Sinn, da eine anschließende Bewegungsanalyse solcher beliebig rekonstruierter Daten mit der Realität beliebig viel (beziehungsweise wenig) zu tun hätte (vergleiche Titelbild und die Bildlegende auf Seite 3). Müssen wir damit unser Vorhaben aufgeben?

Noch nicht, denn wir haben verfügbares Vorwissen nicht ausgenutzt: Volumina mit Partikeln haben die Eigenschaft, dass sie an unbekannten Orten Partikel aufweisen, aber ansonsten „leer“ sind. Dies führt auf folgenden Ansatz zur Rekonstruktion: Berechne ein Volumenbild, das aus einer minimalen Anzahl elementarer Bausteine, den Partikeln, besteht, sodass dieses noch mit den Beobachtungen, das heißt mit den Projektionen der Partikel durch die Kameras, übereinstimmt.

Durch die Forderung nach einer „minimalen“ Anzahl an Partikeln, deren Projektionen mit den Messwerten übereinstimmen, versuchen wir also die Mehrdeutigkeit der Rekonstruktion zu beseitigen. So plausibel dieser Ansatz auch ist, so beantwortet er doch nicht mit Gewissheit, ob eine derartige Rekonstruktion „eindeutig“ ist. Außerdem definiert die Minimierung einer diskretwertigen Größe (Partikelanzahl) unter Nebenbedingungen ein kombinatorisches Optimierungsproblem, das nur mit sehr großem Berechnungsaufwand – man spricht von exponentieller Komplexität – gelöst werden kann.

Erkenntnisse der Mathematik

Im Jahr 2006 erschienen zwei wegweisende Publikationen über folgenden Sachverhalt:

(i)Gegeben sei eine Signalklasse, die mittels elementarer Bausteine so repräsentiert werden kann, dass zur Darstellung jedes konkreten Signals dieser Klasse – in unserem Fall ist das ein Volumenbild – die Anzahl benötigter Bausteine klein ist relativ zur Anzahl der Freiheitsgrade des Signals. In unserem obigen Fallbeispiel ist die Zahl 300 (Partikel) deutlicher kleiner als d3.

(ii)Gegeben sei eine zweite Menge elementarer Bausteine, deren Elemente zu den Bausteinen der ersten Menge in einer bestimmten mathematischen Beziehung stehen. Diese Beziehung sagt aus, dass die Bausteine beider Mengen „wenig miteinander zu tun haben“.

(iii) Kann man nun Messwerte eines unbekannten Signals durch die Bausteine der zweiten Menge darstellen, dann

(a) reichen „weniger“ Messwerte des Signals zu seiner „eindeutigen“ Rekonstruktion aus, als das Signal Freiheitsgrade hat, und

(b) die Rekonstruktion kann durch ein „gutartiges“ Optimierungsproblem „effizient“ mit einem Computer durchgeführt werden.

Dieser Ansatz löst somit grundsätzlich die am Ende des vorigen Absatzes skizzierte Problematik – sofern geeignete Bausteine gefunden werden können.

Blick über das Anwendungsgebiet hinaus

Die eben dargestellten grundlegenden Aussagen bilden den Anfang eines bekannten Zyklus, an dessen Ende in der Regel innovative Technologien stehen:

Mathematiker beweisen zunächst einen Sachverhalt, der vorher so nicht für möglich gehalten wurde. Anschließend versuchen sie, konkrete Objekte (die oben genannten Bausteine) zu konstruieren, anhand derer die abstrakt-mathematische Existenz des Sachverhaltes konkret wird. Ungeachtet ihrer nun „realen“ Existenz sind diese Objekte jedoch oft noch idealisierenden mathematischen Annahmen unterworfen, die in konkreten Anwendungen zumeist nicht erfüllt sind. Einige Ausnahmen, welche für den oben geschilderten Sachverhalt diese Regel bestätigen, haben in jüngster Zeit zu erstaunlichen Fortschritten in speziellen Anwendungen geführt, sodass manche Forscher bereits von einem neuen Zeitalter der Signalverarbeitung schwärmen.

In einer sich anschließenden Phase, die eben erst begonnen hat, versucht man nun, die Lücke zwischen Theorie und Praxis zu schließen, repräsentiert durch eine Vielzahl von Anwendungen, deren Problemstellungen auf einer abstrakten Beschreibungsebene miteinander verwandt sind. Eine dieser Anwendungen ist das oben diskutierte Rekonstruktionsproblem der Experimentellen Strömungsmechanik.

Numerische Untersuchungen weisen deutlich da- rauf hin, dass die Rekonstruktion eines Volumenbildes von Partikeln aus wenigen Projektionen eindeutig gelöst werden kann, abhängig von der Anzahl der Größe und der Unterteilung des Volumens in elementare Zellen, von der Partikeldichte und von der geometrischen Anordnung der Projektionsstrahlen. Es ist die Aufgabe theoretischer Untersuchungen, diese Grenze der Machbarkeit zu fassen und Kriterien für ihre Erkennung im konkreten Anwendungsfall bereitzustellen.

Ein derzeit verfolgter Ansatz besteht darin, die Beziehung zwischen elementaren Zellen des Volumens und Projektionsstrahlen, welche diese treffen, abstrakt als „Kommunikationsnetzwerk“ zu beschreiben. Dies führt zu einem Vergleich mit einer Klasse mathematisch-abstrakter Netzwerke, die – analog zur oben geschilderten Situation – gewünschte Eigenschaften aufweisen und beweisbar existieren, deren konkrete Konstruktion aber, insbesondere unter anwendungsspezifischen Einschränkungen, sehr schwierig ist.

Dieses grundlegende Problem verbindet einige Disziplinen der Mathematik und der Theoretischen Informatik mit einer Reihe wichtiger Anwendungen. Aus diesem Grund kann das Studium von Partikeln in Strömungen Erkenntnisse bringen, die weit über die ursprünglich motivierende Anwendung hinaus bedeutsam sind. Die Experimentelle Strömungsmechanik selbst profitiert von einer direkten Wechselwirkung zwischen mathematischer Modellbildung und industrieller Praxis.

Die langfristige Vision der Experimentellen Strömungsmechanik sind technische Systeme, die Hand in Hand mit Methoden der numerischen Simulation turbulente Strömungen schritthaltend erfassen, um anwendungsrelevante Parameter unmittelbar zu messen oder sogar regelnd zu beeinflussen. Allein schon die in der Abbildung auf Seite 8 (Mitte) genannte Datenrate, die bei zukünftigen Systemen nicht abnehmen wird, verdeutlicht den Umfang dieser Aufgabe. Man darf darauf gespannt sein, ob sich diese Vision in den kommenden zwei Dekaden realisieren wird. Prof. Dr. Christoph Schnörr leitet nach Stationen in Karlruhe, Stockholm, Hamburg und Mannheim seit 2008 den Lehrstuhl für Bildverarbeitung und Mustererkennung an der Universität Heidelberg. Forschungsergebnisse seiner Arbeitsgruppe wurden national und international ausgezeichnet. Er ist Mitherausgeber der Fachzeitschrift mit dem höchsten Impactfaktor auf diesem Gebiet. Zusammen mit zwei weiteren Lehrstühlen leitet er das „Heidelberg Collaboratory for Image Processing“, das im Rahmen der Exzellenzinitiative eine neue Form der Partnerschaft zwischen Grundlagenforschung und Industrie etabliert.

Prof. Dr. Christoph Schnörr leitet nach Stationen in Karlruhe, Stockholm, Hamburg und Mannheim seit 2008 den Lehrstuhl für Bildverarbeitung und Mustererkennung an der Universität Heidelberg. Forschungsergebnisse seiner Arbeitsgruppe wurden national und international ausgezeichnet. Er ist Mitherausgeber der Fachzeitschrift mit dem höchsten Impactfaktor auf diesem Gebiet. Zusammen mit zwei weiteren Lehrstühlen leitet er das „Heidelberg Collaboratory for Image Processing“, das im Rahmen der Exzellenzinitiative eine neue Form der Partnerschaft zwischen Grundlagenforschung und Industrie etabliert.

Kontakt: schnoerr@math.uni-heidelberg.de

Partner des Forschungsprojektes sind das Deutsche Zentrum für Luft- und Raumfahrt (DLR) sowie die Firma LaVision GmbH in Göttingen. Der Autor dankt der Deutschen Forschungsgemeinschaft (DFG) für die Förderung.