Computer nach dem Vorbild des Gehirns?

Wie es gelingen kann, das menschliche Gehirn und seine Arbeitsweise nachzuahmen

von Karlheinz Meier

Etwa tausend Milliarden Nervenzellen sind in unserem Gehirn auf kleinem Raum zu einem Netzwerk verbunden, das manche Wissenschaftler für das komplexeste Gebilde des Universums halten. Bislang ist nur wenig darüber bekannt, wie die Zellen des Gehirns Informationen verarbeiten, wie sie also beispielsweise lernen, wie sie sich erinnern oder sich eigenständig zu neuronalen Ensembles mit besonderen Aufgaben organisieren. Einiges hat unser Hirn mit den derzeit leistungsstärksten Computern gemeinsam – größer jedoch sind die Unterschiede, die es den Wissenschaftlern schwer machen, das Universum im Kopf zu verstehen – und seine Arbeitsweise zu kopieren.

Als Sissa ibn Dahir seinem Herrscher das Schachspiel vorstellte, war der Fürst von der Erfindung seines Untertanen so angetan, dass er ihm einen Wunsch erfüllen wollte. Was sich Sissa daraufhin erbat, schien bescheiden: Er wünschte sich ein Weizenkorn auf das erste Feld des Schachspiels und dann eine Verdopplung der Gabe bis hin zum Feld 64. Doch sein Wunsch erwies sich als unerfüllbar: Bald stellte sich heraus, dass sich auf dem Schachbrett Weizenkornberge türmen würden, die alle vorstellbaren Grenzen sprengen.

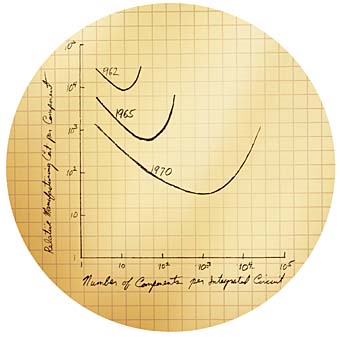

Die „Weizenkornlegende“ soll sich im dritten oder vierten Jahrhundert nach Christus in Indien ereignet haben. Etwas Ähnliches findet derzeit in der modernen Informationsverarbeitung statt, die seit ihrem Anbeginn eine rapide Entwicklung erfährt. Sie lässt sich erstaunlicherweise in nahezu allen Aspekten mit dem oben beschriebenen, einfachen mathematischen Zusammenhang charakterisieren: Die Rechenleistung, die Dichte von Transistoren und viele andere Kenngrößen verdoppeln sich in einem relativ kurzen Zeitraum von etwa zwei Jahren. Mathematisch betrachtet handelt es sich dabei um ein Potenzgesetz, das nach einem Gründer der Firma Intel das „Moore‘sche Gesetz“ genannt wird. Im Gegensatz zu dem mit den Jahren vielleicht linear ansteigenden Umfang einer Briefmarkensammlung besteht hier ein explosionsartiges Wachstum, dessen wahre Dynamik sich häufig erst dann erschließt, wenn die erreichten Zahlen tatsächlich riesig werden – so, wie bei der Weizenkornlegende, wo die wahre Dramatik auch erst auf den letzten Feldern des Schachbrettes sichtbar wird: Jede weitere Verdoppelung macht die einmal erreichte Zahl immer aberwitziger.

| |

|

Wie lernt das Gehirn? Um diese Frage beantworten zu können, gilt es, neuronale Netze von höchster Komplexität zu simulieren. Die Idee für diesen Ansatz ist nicht neu: Entscheidende Vorarbeiten zur technischen Realisierung leistete bereits Mitte des 19. Jahrhunderts Gustav Robert Kirchhoff, Namensgeber des Heidelberger Kirchhoff-Instituts für Physik.

Bild: Universitätsarchiv Bild: Universitätsarchiv

|

Die Frage ist: Sind wir in der Informationstechnologie bereits auf den letzten Feldern des Schachbretts angekommen? Das ist ein viel diskutiertes Thema. Moderne technische Entwicklungen weisen jedoch darauf hin, dass das Ende in absehbarer Zeit noch nicht in Sicht ist. Das Thema ist nicht nur für Computerfachleute interessant – es ist von unmittelbarer Brisanz für uns alle – denn Informationsverarbeitung findet nicht nur auf unserem Laptop im Büro, sondern auch in unserem Kopf statt. Die sich in diesem Zusammenhang aufdrängenden Fragen sind fundamental: Könnte es sein, dass mein Computer irgendwann einmal mehr kann als mein Gehirn? Werde ich von Computern abhängig? Könnte es gar sein, dass mein Computer in Zukunft eigene Intelligenz aufweisen wird? Die ersten beiden Fragen würden einige unter uns vermutlich schon heute mit einem – eingeschränkten – Ja beantworten. Die dritte Frage ist zurzeit noch Stoff für Science-Fiction-Romane.

Trotz aller Ähnlichkeiten bestehen zwischen einem Computer und einem Menschen, der Informationen verarbeitet, grundsätzliche Unterschiede. Das Gehirn enthält keinen fertigen Satz bereits vordefinierter Software-Algorithmen – es muss sich in einem Prozess der Selbstorganisation an die jeweiligen Lebenssituationen anpassen und kann durch Lernprozesse zu mehr oder weniger bemerkenswerten Leistungen befähigt werden. Unser Hirn versetzt uns in die Lage, mit völlig neuen und unerwarteten Situationen fertig zu werden – eine Aufgabe, an der konventionelle Computer regelmäßig scheitern. Das Gehirn kann selbst dann noch sehr leistungsfähig arbeiten, wenn es Schaden genommen hat und weist somit eine bemerkenswerte Fehlertoleranz auf. Ein einziger fehlerhafter Transistor in einem Mikroprozessor hingegen kann das komplette System nutzlos werden lassen. Und schließlich benötigt das Gehirn für seine Leistungen verglichen mit einem PC erstaunlich wenig Energie.

| |

|

|

Noch bemerkenswerter werden die Unterschiede zwischen biologischer und elektronischer Informationsverarbeitung, schaut man sich die mikroskopische Struktur der beiden Systeme an. Das von Ingenieuren entworfene künstliche Computersystem besteht aus unterschiedlichen, hoch spezialisierten Einheiten, etwa verschiedenen Speichertypen und Rechenwerken. Diese Einheiten tauschen binäre Daten (also Nullen und Einsen) untereinander aus, die sowohl Informationen als auch Instruktionen für deren Verarbeiten repräsentieren. Die Rechenregeln für das Bearbeiten dieser binären Daten werden durch die Algebra beschrieben, die der Mathematiker George Boole im Jahr 1847 ersonnen hat. Das Austauschen und Verarbeiten der binären Daten erfolgt dabei strikt synchron in einer Frequenz, deren Takt von einer zentralen Uhr vorgegeben wird. Die Schnelligkeit dieser zentralen Taktgeber hat in den letzten Jahren stark zugenommen und liegt heute bei einigen Milliarden Zyklen pro Sekunde. Diese Einheit bezeichnet man als Gigahertz (GHz). Aufgrund des synchronen Taktes lässt sich der Zustand eines solchen Computers zu jedem beliebigen Zeitpunkt vollständig speichern und auf andere Systeme übertragen. Die Architektur moderner Computer folgt grundsätzlich der von dem Physiker und Mathematiker John von Neumann um 1945 beschriebenen von Neumann-Maschine.

| |

|

Welches Konzept hat das Gehirn für das Verarbeiten von Informationen? Die Komplexität der Informationsverarbeitung – soviel steht fest – beruht im Hirn weniger auf hoher Geschwindigkeit als auf großen Zahlen. Auch Computer erzeugen Komplexität aus extrem vielen vernetzten Übertragungselementen. Sehr große, aus zehntausenden von Einzelrechnern bestehende Computer sagen beispielsweise das Wetter vorher oder analysieren Wirtschaftssysteme.

|

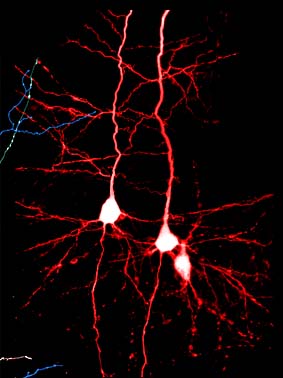

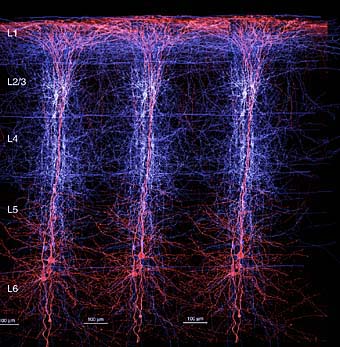

Die mikroskopische Struktur des menschlichen Gehirns ist sowohl in seiner Architektur als auch in seiner Dynamik erheblich vom Computer verschieden. Für die Großhirnrinde, den „Kortex“, des Menschen liegt seit langem eine räumliche Kartierung vor, die beispielsweise zeigt, wo bestimmte Sinneseindrücke oder motorische Funktionen verarbeitet werden. Trotz dieser funktionalen Spezialisierung weist das System Kortex mikroskopisch betrachtet eine erstaunliche räumliche Uniformität auf – allein das unterscheidet es bereits von einem Mikroprozessor mit seinen deutlich unterscheidbaren Einheiten. Die etwa 1012 (1000 Milliarden) Nervenzellen (Neuronen) des Gehirns sind über etwa 1015 (1000 mal 1000 Milliarden) synaptische Verbindungen miteinander verknüpft. Die räumliche Distanz zwischen den Nervenzellen wird dabei durch ein Netzwerk von Axonen (wegleitende Verbindungen) und Dendriten (hinleitende Verbindungen) überwunden. Der Kortex ist einige Millimeter dick und weist durchgehend sechs Schichten auf mit jeweils charakteristischen Zelltypen und Verbindungsstrukturen.

Bemerkenswert ist, dass die Kommunikation zwischen den Nervenzellen – genau wie beim Computer – zumindest teilweise mithilfe standardisierter elektrischer Pulse erfolgt. Solche so genannten Aktionspotenziale oder „Spikes“ entsprechen relativ geringen elektrischen Spannungen (etwa 0,1 Volt) und sind verglichen mit dem elektronischen Vorbild sehr langsam. Das Ein- und Ausschalten eines solchen Pulses dauert immerhin eine tausendstel Sekunde; viel häufiger als etwa zehn Mal pro Sekunde sendet eine typische Nervenzelle nicht. Die standardisierten Pulse legen auf den ersten Blick einen direkten Vergleich mit dem Computer nahe – es gibt jedoch einen zentralen Unterschied: Der mögliche Zeitpunkt für das Aussenden eines Aktionspotenzials ist im biologischen System nicht durch einen zentralen Takt vorgegeben. Mit anderen Worten: Das neuronale Netzwerk ist asynchron.

| |

|

Von Gordon Moore, dem Begründer der amerikanischen Firma Intel, stammt das "Moore'sche Gesetz". Es besagt, dass die Rechenleistung, die Dichte von Transistoren und viele weitere Kenngrößen moderner Informationsverarbeitung in einem relativ kurzen Zeitraum von etwa zwei Jahren verdoppeln.

|

Woher erhält es dann aber den Befehl zu „feuern“? Dieser Befehl kommt aus dem Netzwerk selbst! Eine Nervenzelle sammelt über ihren weit verzweigten Dendritenbaum Signale von bis zu 10 000 Neuronen auf, wobei als intelligente Schaltstellen zwischen den Nervenzellen die Synapsen fungieren. Die elektrischen Signale versuchen nun, einen „Kondensator“ – die Membran der Nervenzelle – elektrisch aufzuladen. Dabei gibt es jedoch außerordentlich viel Konkurrenz: Einige Synapsen tragen zum elektrischen Aufladen bei (erregende Synapsen), andere hingegen ziehen Ladung ab (hemmende Synapsen). Der Kondensator der Nervenzelle ist zudem etwas „undicht“ und verliert von selbst Ladung (Leckströme). Trotz dieser Wettbewerbssituation um die Ladung in der Nervenzelle erreicht die elektrische Spannung der Membran irgendwann einen magischen Wert: die „Feuerschwelle“ zum Aussenden eines Aktionspotenzials. Der elektrische Einheitspuls wird über das Axon in das Netzwerk gesandt. Anschließend beginnt der Prozess des Aufladens der Membran erneut.

2 500 Gigabyte pro Sekunde

Es ist offensichtlich, dass sich ein solches Netzwerk aus rund 1000 Milliarden Nervenzellen nicht ohne weiteres durch ein analytisches mathematisches Modell beschreiben lässt. Die Situation ist noch hoffnungsloser als der Versuch, die Bewegung aller Teilchen in einem Luftballon zu beschreiben. Während im Luftballon mit etwa 1023 Teilchen ein thermisches Gleichgewicht herrscht, in dem einfache globale Größen wie Temperatur und Druck über simple Gleichungen verknüpft werden können, ist ein vergleichbarer Ansatz beim neuronalen Netzwerk kaum möglich. 1000 Milliarden Neuronen mit einer Feuerrate von einem Hertz erzeugen pro Sekunde eine Informationsmenge von 2 500 Gigabyte, wenn man für die Beschreibung von Ort und Zeit eines Aktionspotentials einen Informationsbedarf von nur 20 Bits ansetzt. Diese Information ist auf irgendeine Weise für das verantwortlich, was wir als die erstaunliche Leistung des Gehirns bezeichnen. Mit einfachen globalen Größen werden wir der Frage nach dem Funktionsprinzip des Hirns wohl kaum auf die Spur kommen können.

Die Komplexität der Informationsverarbeitung des Gehirns beruht also vermutlich auf großen Zahlen – und nicht auf hoher Geschwindigkeit. Systeme, die Komplexität aus extrem vielen vernetzten Übertragungselementen erzeugen, bezeichnet man auch als massiv parallel. Parallelität ist ein aktuelles und stark wachsendes Arbeitsgebiet der modernen Informationstechnologie. Das Verknüpfen von Computern zu sehr großen Clustern, die aus zehntausenden von Einzelrechnern bestehen, erlaubt es heute, das Wetter, Verbrennungsprozesse oder Wirtschafts- und Sozialsysteme zu analysieren. Im Wettbewerb um den leistungsfähigsten Cluster der Welt wird alljährlich die „TOP-500-Liste“ kreiert, die derzeit von einem IBM-BlueGene/L-Rechner am amerikanischen Lawrence Livermore Laboratory mit 131 072 Prozessoren angeführt wird. Es liegt nahe, solche Systeme einzusetzen, um neuronale Netzwerke zu simulieren und besser zu verstehen. Dies geschieht derzeit in einer Reihe von Forschungsprojekten. Am bekanntesten ist vermutlich das an der „Ecole Polytechnique Fédérale de Lausanne“ gerade begonnene BlueBrain-Projekt des Neurowissenschaftlers Henry Markram. Ihm stehen achttausend IBM-Prozessoren zur Verfügung, um große Netzwerke zu simulieren.

Offensichtlich sind aber selbst einhunderttausend Prozessoren noch zu wenig – verglichen mit 1012 Nervenzellen im Kortex. Mit der simplen Gleichung „ein Neuron = ein Prozessor“ werden sich so bald also keine Netzwerke von wirklich biologischer Komplexität simulieren lassen. Dazu bräuchte man zehn Millionen mal mehr Computerknoten im Netzwerk. Natürlich kann ein moderner Prozessor gleichzeitig viele Nervenzellen simulieren, also gewissermaßen ein Teilnetzwerk repräsentieren. Dies verlangsamt jedoch notwendigerweise die Simulation. Es ist tatsächlich so, dass die Simulation von Netzwerken mit extrem hoher Komplexität zwar möglich ist – jedoch erheblich langsamer abläuft als die Prozesse des biologischen Vorbilds. Dies macht es schwierig, Lernprozesse zu untersuchen, da diese bereits im biologischen System langsam sind: Lernen dauert Stunden, wenn nicht gar Tage oder Monate.

| |

|

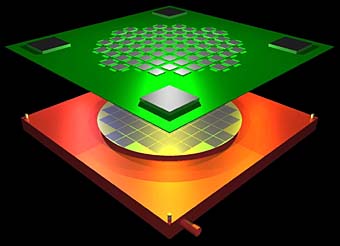

Die Wissenschaftler des Heidelberger Kirchoff-Instituts für Physik entwickeln derzeit einen Neurocomputer mit einer halben Million Nervenzellen und einer Milliarde Verbindungen (Synapsen).

|

Ein Kondensator als Modell

Unsere Arbeitsgruppe am Heidelberger Kirchhoff-Institut für Physik verfolgt seit einigen Jahren einen alternativen Ansatz, um neuronale Netze höchster Komplexität zu simulieren. Das Prinzip: Wenn die Funktion einer Nervenzelle mit einem elektrischen Kondensator verglichen werden kann, könnte man diesen Kondensator nicht nur mithilfe eines Computers simulieren, sondern gleich einen richtigen Kondensator verwenden. Es geht also um den Bau elektronischer Schaltungen, die wie Zellen und biologische Netzwerke funktionieren. Die Idee für diesen Ansatz ist alt: Sie geht auf den Physiker Carver Mead, einen Schüler des amerikanischen Nobelpreisträgeres Richard Feynman, zurück, der in den 1980er Jahren solche Systeme am „California Institute of Technology“, kurz CalTech, gebaut hat. Die Prinzipen für den Transport elektrischer Ladungen sind noch älter. Sie wurden Mitte des 19. Jahrhunderts vom Namensgeber des Heidelberger Institutes, dem Physiker Gustav Kirchhoff, in Form der weithin bekannten Kirchhoff'schen Regeln entwickelt.

Im einfachsten Modell ist eine Nervenzelle ein elektrischer Kondensator mit einem parallel geschalteten Widerstand. Die Ruhespannung wird durch eine Batterie definiert, die erregenden und hemmenden Synapsen sind hinein- und hinausfließende Ströme, und die Feuerschwelle wird durch eine moderne elektronische Schaltung, einen so genannten Komparator, realisiert. All diese Elemente müssen nicht aus einzelnen elektronischen Bauteilen zusammengelötet werden: Die moderne Mikroelektronik ermöglicht es, ein neuronales Netzwerk aus „einem Guss“ im Rahmen eines Prozesses herzustellen, der auch für die Produktion von Chips in Telefonen und Waschmaschinen verwendet wird. Diese Technologie bezeichnet man als „Very Large Scale Integration“, als Integration auf großer Skala. Mit der „großen Skala“ ist hier die Menge von Bauteilen pro Chipfläche gemeint. Für die Produktion komplexer Neuroschaltungen ist dies die wichtigste Eigenschaft.

Bisher war beim Entwurf einer „Ersatzschaltung“ nur von Nervenzellen die Rede. Mindestens genauso wichtig sind aber die Kontaktstellen, die Synapsen. Und zwar aus zweierlei Gründen: Zum einen gibt es viele tausend Mal mehr Synapsen als Nervenzellen. Ein banales Argument wie der Platzbedarf wird so plötzlich zum bestimmenden Element der Realisierbarkeit. Zum anderen sind die Synapsen zumindest teilweise dafür verantwortlich, dass sich neuronale Netze selbstständig organisieren. Diese Fähigkeit wird von Neurowissenschaftlern als „Plastizität“ bezeichnet. Für den „Heidelberger Neurochip“ ist die Plastizität die wichtigste Herausforderung. Sowohl die Nervenzellen als auch die Synapsen werden von uns als analoge Schaltungen realisiert. Es handelt sich also in gewisser Weise um eine Rückkehr zur alten Idee des Analogrechners. Wegen der identischen Funktionsweise des biologischen Vorbildes ist dies eine interessante Idee.

| |

|

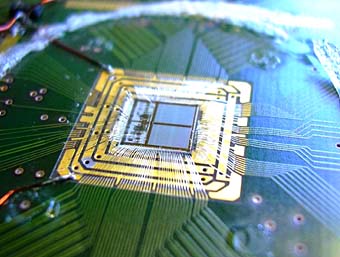

Der "Heidelberger Netzwerkchip": 5x5 mm klein, mit 384 künstlichen Nervenzellen und 100.000 Synapsen

|

Es fehlt jedoch noch ein Element: das Aktionspotenzial – die eigentliche Information im Netzwerk. Natürlich sind die Aktionspotenziale im biologischen System auch analoge Spannungsverläufe, jedoch sind sie mit sehr guter Genauigkeit alle identisch. Aktionspotenziale im biologischen Netzwerk tragen eigentlich nur zwei Informationen: „woher?“ und „wann?“. Dieses Woher-und-wann entspricht genau dem elektrischen Prinzip in unseren vertrauten Computernetzwerken. Auch dort sind alle Impulse gleich – nur das Muster zählt. Wir haben uns aus diesem Grund dazu entschlossen, analoge und digitale Elektronik im Neurochip zu kombinieren: Die lokale Informationsverarbeitung in den Zellen (Synapsen und Neuronen) ist analog, die Kommunikation über Aktionspotenziale erfolgt mit konventioneller Digitalelektronik. Der Vorteil dieses Ansatzes liegt auf der Hand: Durch den Einsatz perfekt entwickelter Schalttechnik zum Übertragen digitaler Daten mit höchsten Geschwindigkeiten lassen sich in der Größe fast beliebig skalierbare Netze aufbauen, die in biologisch relevante Größenordnungen vorstoßen.

Die beschriebenen synthetischen Neuroschaltungen haben eine Reihe bemerkenswerter Eigenschaften. So sind die verwendeten Kondensatoren im Nervenzellmodell ausgesprochen klein. Viel kleiner als kommerziell erhältliche Einzelbauelemente. Kleine Kondensatoren werden sehr schnell aufgeladen und entladen. Verglichen mit dem biologischen Vorbild laufen die Heidelberger Netzwerkchips darum etwa einhunderttausend Mal schneller. Um Hirnvorgänge wie Plastizität und Lernprozesse zu untersuchen, ist diese Eigenschaft ausgesprochen wichtig. Denn die neuronale Dynamik eines Tages lässt sich so auf dem Chip zu einer Sekunde komprimieren. Auf diese Art und Weise kann die Funktion von Netzwerken mit vielen veränderten Parametern systematisch untersucht werden. Eine andere wichtige Eigenschaft ist die Energieaufnahme. Im Gegensatz zur Lösung einer mathematischen Differentialgleichung erfordert das Aufladen eines Kondensators wenig Energie. Ein über weite Strecken analoges Modell eines neuronalen Netzes ist also ähnlich energieeffizient wie das biologische Vorbild.

Künstliche Nervenzellen

All diese Arbeiten müssen interdisziplinär erfolgen: Physiker wissen „von Haus aus“ nur wenig von der Neurobiologie, Informatikern ist die analoge Mikroelektronik eher fremd und Neurowissenschaftler haben üblicherweise kaum etwas mit dem Bau großer elektronischer Systeme zu tun. Die Europäische Union hat deshalb das Förderprogramm „Future Emerging Technologies“ aufgelegt, in dem grundlegend neue Prinzipien der Informationsverarbeitung interdisziplinär entwickelt werden sollen. „Quanteninformation“ und „biologisch inspirierte Systeme“ sind zwei Beispiele für Förderprojekte, an denen Heidelberger Gruppen beteiligt sind. Die Arbeitsgruppe des Kirchhoff-Instituts koordiniert in diesem Rahmen das so genannte FACETS-Projekt, wobei FACETS für „Fast Analog Computing with Emergent Transient States“ steht. Fünfzehn europäische Gruppen aus den Bereichen Neurobiologie, Informatik, Physik und Elektrotechnik werden in diesem Projekt mit rund zehn Millionen Euro für vier Jahre gefördert. Nähere Informationen finden sich im Internet unter www.facets-project.org.

Worum soll es bei diesem Projekt konkret gehen? Es gilt zunächst, ein synthetisches neuronales Netzwerk nach dem beschriebenen elektronischen Prinzip zu bauen. In einer ersten Entwicklungsstufe werden dazu viele individuelle, fünf mal fünf Millimeter große Netzwerkchips zu einem „Neurocomputer“ kombiniert, der mit etwa einhunderttausend künstlichen Nervenzellen und 25 Millionen Synapsen einem Volumen des menschlichen Kortex von ungefähr einem Kubikmillimeter entspricht. Dieses System ist in mechanische Rahmen eingebaut, deren Erscheinungsbild noch sehr an konventionelle Computer erinnert. Die künstlichen Nervenzellen in diesem System ähneln aber bereits stark dem biologischen Vorbild und beherrschen verschiedene Mechanismen der Plastizität. Ein Prototyp-Chip ist bereits funktionsfähig und hilft uns, vorbereitende Experimente durchzuführen. So konnten beispielsweise schon die Plastizität und das charakteristische Verhalten der neuronalen Membranspannung experimentell nachgewiesen werden.

In der zweiten Entwicklungsstufe soll der in Computern übliche Ansatz des Verschaltens individueller Mikrochips zugunsten eines großen, fast uniformen Siliziumsubstrats aufgegeben werden. Eine zwanzig Zentimeter große Siliziumscheibe wird etwa eine halbe Million künstlicher Nervenzellen und eine Milliarde Synapsen beherbergen, die mithilfe 180 Nanometer großer Strukturen (Transistoren) aufgebaut werden. Oberhalb dieser Siliziumscheibe ist eine elektronische Schaltung montiert, die dazu dient, das Netzwerk zu konfigurieren, die Aktivität des Netzwerks zu analysieren und weit reichende Verbindungen im Netzwerk zu realisieren. Hundert oder mehr solcher Systeme können im Prinzip künstliche Netzwerke mit zehn Millionen Neuronen und 100 Milliarden Synapsen realisieren. Dies entspräche tausend Kubikmillimetern Kortex und würde rund zehn Prozent derjenigen Region des menschlichen Kortex ausmachen, die für einen Teil der visuellen Leistung des Menschen verantwortlich ist. Derartige technische und physikalische Entwicklungsarbeiten sind möglich, weil wir im ständigen wissenschaftlichen Austausch mit Kollegen aus der Neurobiologie stehen, was uns in die Lage versetzt, neueste neurobiologische Ergebnisse unmittelbar in elektronische Schaltungen umzusetzen.

Als Ergebnis erhoffen wir uns neue Erkenntnisse auf zwei Arbeitsgebieten, die recht verschieden voneinander sind. Zum einen sollen die Funktionsprinzipien der neuronalen Informationsverarbeitung experimentell untersucht und mit biologischen Resultaten verglichen werden. Aufschlussreiche Erkenntnisse könnten sich vor allem aus der neuen Möglichkeit ergeben, die Dynamik komplexer neuronaler Schaltungen über große Zeitskalen zu verfolgen. Die biologische Zeitskala von Millisekunden bis hin zu Jahren kann durch die neue Elektronik auf Nanosekunden bis Minuten komprimiert werden.

Das bietet einen Zugang, um Prozesse der Selbstorganisation und des Lernens zu untersuchen. Für den Physiker interessant ist vor allem das zweite Projektziel: das Entwickeln neuer Architekturen zum Verarbeiten von Informationen, in denen Eigenschaften wie Fehlertoleranz und Energieeffizienz bereits „konzeptionell“ eingebaut sind. Für die zukünftige Nutzung neuer Bauelemente, etwa molekulare Schalter oder Kohlenstoff-Nanoröhren, werden solche Konzepte unter Umständen sehr bedeutend – und Computer nach dem Vorbild des menschlichen Gehirns vielleicht doch eines Tages möglich sein.

| |

|

Karlheinz Meier ist Professor für Experimentalphysik an der Fakultät für Physik und Astronomie der Universität Heidelberg. Er ist Gründer des Kirchhoff-Instituts für Physik und des Heidelberger ASIC-Laboratoriums für Mikroelektronik. Die Arbeiten auf dem Gebiet der biologisch inspirierten Informationsverarbeitung ergaben sich aus apparativen Entwicklungen der Elementarteilchenphysik, in der ebenfalls große mikroelektronische Systeme zur Informationsverarbeitung entwickelt und gebaut werden.

|